Recentemente, um excerto de um texto meu, publicado aqui na Folha a propósito do uso da Inteligência Artificial (IA), foi utilizado em uma prova de admissão para professores no estado de São Paulo.

O trecho, adaptado, fora retirado de uma coluna onde discuto os desdobramentos éticos e práticos do uso disseminado da IA, especialmente em conteúdos que nos chegam de maneira quase invisível.

Como eu não sou candidato a professor na prefeitura de Barueri, provavelmente nunca saberia desse fato, mas uma das professoras encarregadas de o corrigir me abordou no Instagram:

"Oi, boa tarde. Eu li um texto seu recentemente sobre o uso de IA na criação de conteúdos. (Li numa prova de concurso). Lá você diz que quem usa IA sabe que, no final, todo o conteúdo produzido pode cair debaixo do rótulo de 'conteúdo sintético'. Com conteúdo sintético você quer dizer de algo que foi totalmente produzido por IA?"

A escolha do meu texto para um exame educacional deveria ser motivo de satisfação, pela aparente valorização do conteúdo. Contudo, a forma como foi utilizado suscita questões sobre ética, direitos autorais e responsabilidade intelectual.

O segmento usado, elaborado pelo "Instituto Mais", embora um reconhecimento implícito da relevância do tema, foi apresentado de maneira truncada e descontextualizada, sem indicação da fonte, e a pergunta baseada no texto deturpava sua essência, propondo um significado de "conteúdo sintético" que não corresponde ao conceito que abordo.

O problema não reside só na utilização incompleta do texto, mas no fato de que as nuances de uma discussão complexa sobre IA foram comprimidas em uma questão de múltipla escolha.

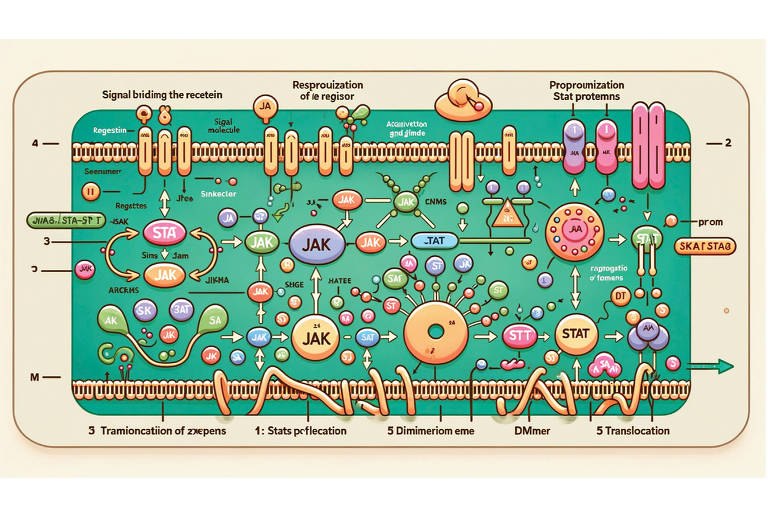

A IA não é mais uma promessa futurista; ela é uma realidade presente em nossas vidas cotidianas, modelando desde a nossa absorção de notícias até as estratégias de marketing político.

Por essa razão, insisto na importância de uma discussão franca sobre a tecnologia. Seu uso não deve ser escondido, mas sim revelado, garantindo que a sociedade possa se beneficiar de suas vantagens e estar ciente de seus riscos.

A questão levantada na prova de Barueri se enquadra em uma falha maior: na simplificação excessiva de questões complexas, o que pode levar a uma compreensão falha e a decisões mal informadas. Se vamos preparar nossos alunos e professores para o mundo que está se formando, a profundidade e a integridade do conteúdo não podem ser comprometidas.

Diante disso, reforço a necessidade por transparência no uso da IA e a necessidade de um acesso mais igualitário à tecnologia.

Questões como "Por que você usa inteligência artificial?" e "Por que você não usa?" devem ser feitas com a compreensão de que a tecnologia, assim como a caixa de Pandora da mitologia grega, vem com imenso potencial tanto para o bem quanto para o malefício.

É nossa responsabilidade enquanto sociedade, educadores, formuladores de políticas e intelectuais, garantir que o lado benéfico prevaleça. As complexidades do nosso tempo exigem um diálogo mais robusto do que o permitido por questões de teste simplificadas.

Como autor e defensor da cidadania da língua, vejo como imperativo que todos aqueles que contribuem para o desenvolvimento e a disseminação do conhecimento tenham suas vozes e suas obras respeitadas e apresentadas com precisão e integridade. Somente assim podemos aspirar a uma compreensão plena e a um uso ético das ferramentas que definirão nosso futuro.

CORREÇÃO DO AUTOR

As alternativas propostas para a pergunta sobre o significado de "conteúdo sintético" de acordo com o texto são:

(A) Aquele em que o autor não admite ter usado IA na produção.

(B) Um conteúdo que parece artificial para quem o consome.

(C) Uma produção na qual IA foi utilizada em qualquer momento.

(D) Qualquer produção que tenha sido totalmente feita por IA.

Nenhuma está correta. Seria preciso uma nova alínea que acrescentasse:

(E) O conceito não se aplica, porque é impossível comprovar o uso de IA.

Nenhum comentário:

Postar um comentário